Znanstvenici iz Kine i Ujedinjenog Kraljevstva zapravo su poboljšali Adamov optimizacijski algoritam kako bi postigli mnogo bolje detekcije prašine na fotonaponskim pločama. Poboljšani algoritam očito se pokazao puno boljim od većine tipičnih algoritama koji se koriste za otkrivanje prašine.

16. veljače 2024. Lior Kahana

Globalna skupina istraživača uspostavila je jedinstven pristup otkrivanju prašine za fotonaponske sustave. Potpuno nova metoda temelji se na dubokom poznavanju i koristi poboljšanu varijaciju algoritma za optimizaciju adaptivne minutne evaluacije (Adam), koji se obično koristi za treniranje mreža.

“Adamov algoritam integrira prednosti gradijentnog spuštanja i pristupa zamahu, s ciljem adaptivne promjene stope znanja”, raspravljali su istraživači. “Međutim, Adamov algoritam ponekad se bavi problemima kao što su padanje ispod regionalnih optimuma i visoka računalna zamršenost.”

Kako bi se riješili tih problema, akademici su predložili da se u algoritam ugrade Warmup metode i metode kosinusnog žarenja. Metoda Warmup koristi malu stopu znanja u ranim fazama treninga, polako je povećavajući. “Ovo pomaže dizajnu da puno bolje provjeri područje kriterija u ranim fazama obuke, sprječavajući probleme s oscilacijom ili divergencijom izazvane ekstremnom stopom znanja”, dodali su.

Tehnika kosinusnog žarenja, s druge strane, pokreće redovitu promjenu stope saznanja između optimalne i minimalne stope saznanja, u skladu s krivuljom žarenja kosinusne funkcije. “Ova tehnika pomaže da se izbjegne problem oscilacije izazvan brzom brzinom spuštanja gradijenta, čime se poboljšava stabilnost treninga i učinkovitost generalizacije dizajna”, raspravljali su znanstvenici.

Algoritmi

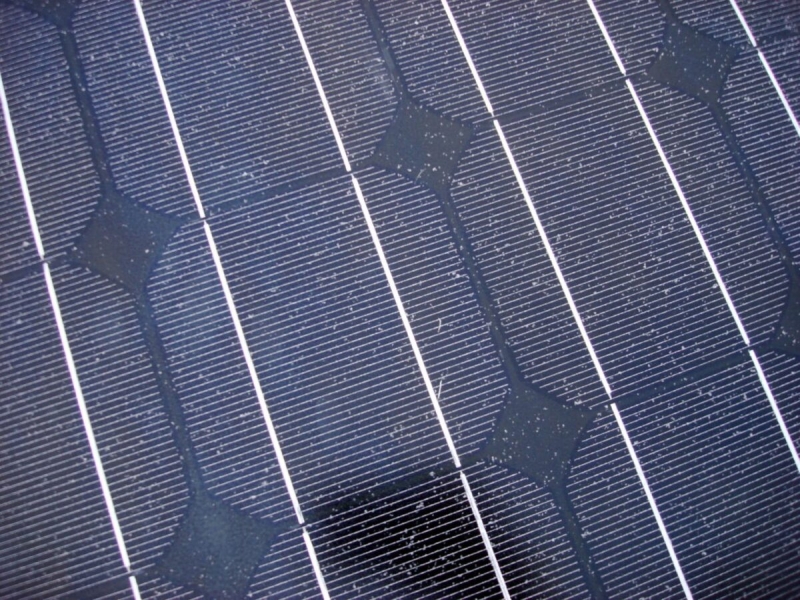

Kako bi provjerili Adamov algoritam, skupina je prikupila skup podataka slika fotonaponskih modula, nekoliko njih urednih i nekoliko očišćenih. Skup podataka sastojao se od 3260 fotografija, a bio je podijeljen u skupove za obuku, prepoznavanje i pregled u omjeru 7:2:1.

Znanstvenici su procijenili algoritam s jedinstvenom arhitekturom neuronske mreže nazvanom ResNet-18 i usporedili njegovu učinkovitost s onom 5 drugih algoritama otkrivanja. Otkrili su da je predloženi algoritam postigao konkurentne rezultate, s preciznošću od 72,45% i gubitkom od 0,5301.

Popularan materijal

Nasuprot tome, takozvani Nadam (Nesterov-ubrzana procjena adaptivnog momenta) algoritam je postigao preciznost od 74,08% i gubitak od 0,7961; neoptimizirani Adamov algoritam postigao je 71,13% u preciznosti i 0,7718 u gubitku, dok je algoritam stohastičkog gradijenta (SGD) dosegao 69,43% odnosno 1,4246. Adagrad algoritam, s druge strane, postigao je 73,77% preciznosti i 0,5202 gubitaka u fazi obuke, dok je RMSprop algoritam postigao 72,01% odnosno 0,7773.

Razne arhitekture

“Naš predloženi poboljšani algoritam postigao je najbolju učinkovitost uz korištenje GPU-a, pokazujući da poboljšani algoritam treba manje resursa da završi isti posao obuke”, izjavili su. “Štoviše, zapravo su postignuti izvrsni rezultati u pogledu vremena treninga.”

Grupa je također procijenila poboljšani Adamov algoritam u različitim arhitekturama neuronskih mreža, posebno ResNet-18, VGG-16 i MobileNetV2. Otkrili su da je ResNet-18 pokazao preciznost od 95,12% i gubitak od 0,14083;